La investigación ha utilizado como campo de estudio dos afluentes del río Támesis para medir la presencia de crecimientos masivos de microalgas

23 de octubre de 2023

La monitorización de la calidad del agua es una tarea prioritaria para contribuir a la conservación de este recurso esencial para la vida. Recientemente,

el último informe de Naciones Unidas sobre el progreso global en la Agenda 2030 para el Desarrollo Sostenible,

ha reconocido que la falta de datos relativos a la calidad del agua, especialmente en los países menos desarrollados,

supone

un riesgo para la salud de más de 3.000 millones de personas, por lo tanto, se hace cada vez más necesario aplicar medidas de detección, antes de que se produzca un deterioro severo del medio acuático en estas zonas.

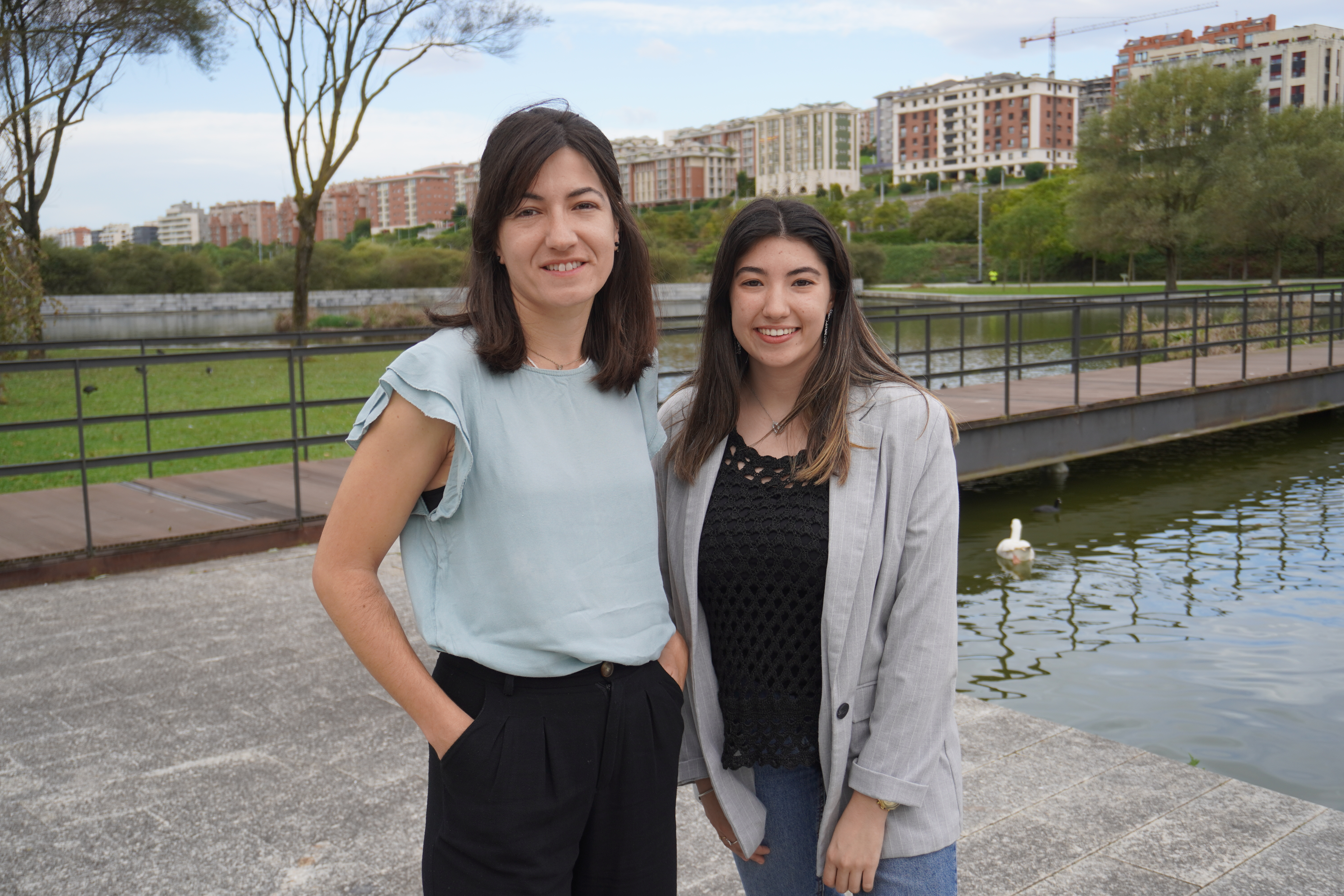

Por ello, un equipo tres de investigadores del Grupo de Computación y e-Ciencia del IFCA, Judith Sáinz-Pardo, María Castrillo, y Álvaro López,

ha desarrollado un modelo de aprendizaje profundo (deep learning), capaz de estimar la concentración de clorofila en el agua, mediante técnicas que se miden con sensores robustos, más económicos y de uso común que los existentes. El trabajo se ha

publicado en la revista Water Research, que ocupa el primer puesto en el campo de Recursos Acuáticos según

Journal Citation Reports (JCR).

“La clorofila aparece cuando en las masas de agua se dan crecimientos de microalgas. Gracias a este tipo de sensores podemos detectar, de forma temprana, la aparición masiva de estos organismos, como ha ocurrido recientemente con episodios en los que ha habido casos de gastroenteritis”, explica

Castrillo. “Igualmente se podría aplicar para la medición de otro tipo de contaminantes como serían los nutrientes, o incluso contaminantes emergentes, que cada vez cobran mas importancia en las agendas de gobernanza del agua”, afirma la investigadora.

María Castrillo y Judith Sáinz-Pardo, en el Parque de Las Llamas de Santander.

Actualmente,

estas partículas presentes en las masas de agua se miden con sensores ópticos, sin embargo, debido a algunos inconvenientes como su coste o necesidades de mantenimiento, su uso está muy limitado y no ofrecen información en tiempo real que garantice una gestión adecuada de los riesgos que implican estos episodios de contaminación.

Esta investigación ha utilizado como modelos dos afluentes del río Támesis, y se han tomado datos de variables físico-químicas de sus aguas, como la temperatura, su pH y conductividad, junto con datos de variables meteorológicas como la irradiancia solar (la energía solar total que incide en una superficie, durante un tiempo determinado), la temperatura ambiente y velocidad del viento. Con este conjunto de datos se logra estimar la concentración de clorofila de estas masas de agua.

Vista microscópica de la clorofila. Pexels

Un modelo de IA global y eficaz

El equipo investigador ha entrenado un modelo basado en

aprendizaje profundo (deep learning), con tres enfoques de aprendizaje que se conocen como: individual, centralizado y federado. Lo que se busca con estos tres enfoques, es

comprobar cuál de ellos es el más adecuado cuando se trabaja con diferentes lugares de estudio, como es el caso de los dos afluentes del Támesis.

La investigadora

Judith Sáinz-Pardo, explica que, este tipo de arquitecturas que son "la parte más novedosa de este estudio, ya que en este campo no se habían aplicado antes”, son las que se conocen como

aprendizaje federado. "Lo que hemos conseguido es

entrenar un modelo global sin necesidad de centralizar los datos de los dos ríos, lo que hacemos es tomar los datos de cada uno de los ríos de forma descentralizada, es decir, distribuida, entrenamos la red neuronal, y después un servidor se encarga de agregar ese modelo, para construir un modelo global”, indica la investigadora del IFCA. “Y nos permite generalizar mejor que otras casuísticas clásicas, ante datos que no han sido vistos previamente por el modelo”, añade Sáinz-Pardo.

Además de esta precisión en el estudio de la calidad de agua, lo que se consigue con esta investigación es

reducir los costes que implica trabajar con grandes volúmenes de datos, y que, en ocasiones, impiden seguir con los estudios por cuestiones de privacidad, seguridad, o limitaciones técnicas, como la falta almacenamiento de datos, o de conectividad de red. “Así, no es necesario compartir los datos en bruto obtenidos en cada río, ni que tengan que ‘viajar’ de los dispositivos que los midieron”, lo que reduce, explica

Sáinz-Pardo, “no solo

el coste en memoria de almacenamiento en un sólo servidor, si no el

coste computacional, es decir, “la cantidad de recursos necesarios para entrenar el modelo y llevar a cabo las predicciones”, afirma la investigadora. Este trabajo supone un

ejemplo de transferencia de conocimiento a empresas u otros organismos públicos de investigación que quieran implantarlo, ya que, mediante un nuevo entrenamiento del modelo, se podrían estudiar nuevas masas de agua.

Rebeca García / IFCA Comunicación